Danmark har netop åbnet for vaccination af 5-11 årige børn mod Corona-virus (min søn skal have det første stik Pfizer i næste uge).

Det er en god udvikling i lyset af, at der bliver ved med at dukke nye varianter op (hej Omikron!), og at smitten i det meste af Europa igen er på et niveau, hvor det er nødvendigt at genindføre sociale restriktioner (hej igen mundbind!). Ved at udbrede vaccination til børnegruppen øger vi flokimmuniteten. Det beskytter de mest sårbare, begrænser behovet for sociale restriktioner, og reducerer den lille risiko vi alle sammen har, selv de unge og fuldt vaccinerede, for at blive alvorligt syge af COVID.

Vaccineskeptikere har imidlertid behandlet dette som en kærkommen lejlighed, til at lufte både gamle klassikere og nye opfindelser. Desværre.

Desværre fordi de forskere, som arbejder med Corona har rigeligt andet at se til. De studerer selvfølgelig vacciner og deres effekter, men også for eksempel effekten af forskellige typer behandling, hvilke tiltag som bedst beskytter sundhedspersonale der arbejder med COVID-patienter, de bedste måder at begrænse smitte i forskellige sammenhænge (plejehjem, børnehaver, etc.), effekten af rejserestriktioner, kvaliteten af forskellige tests, og meget mere. Det er vigtigt arbejde, som de gerne skulle bruge deres tid på. Hvis de i stedet skal bruge tiden på at punktere vaccineskeptisk misinformation, så går deres egentlige forskning langsommere.

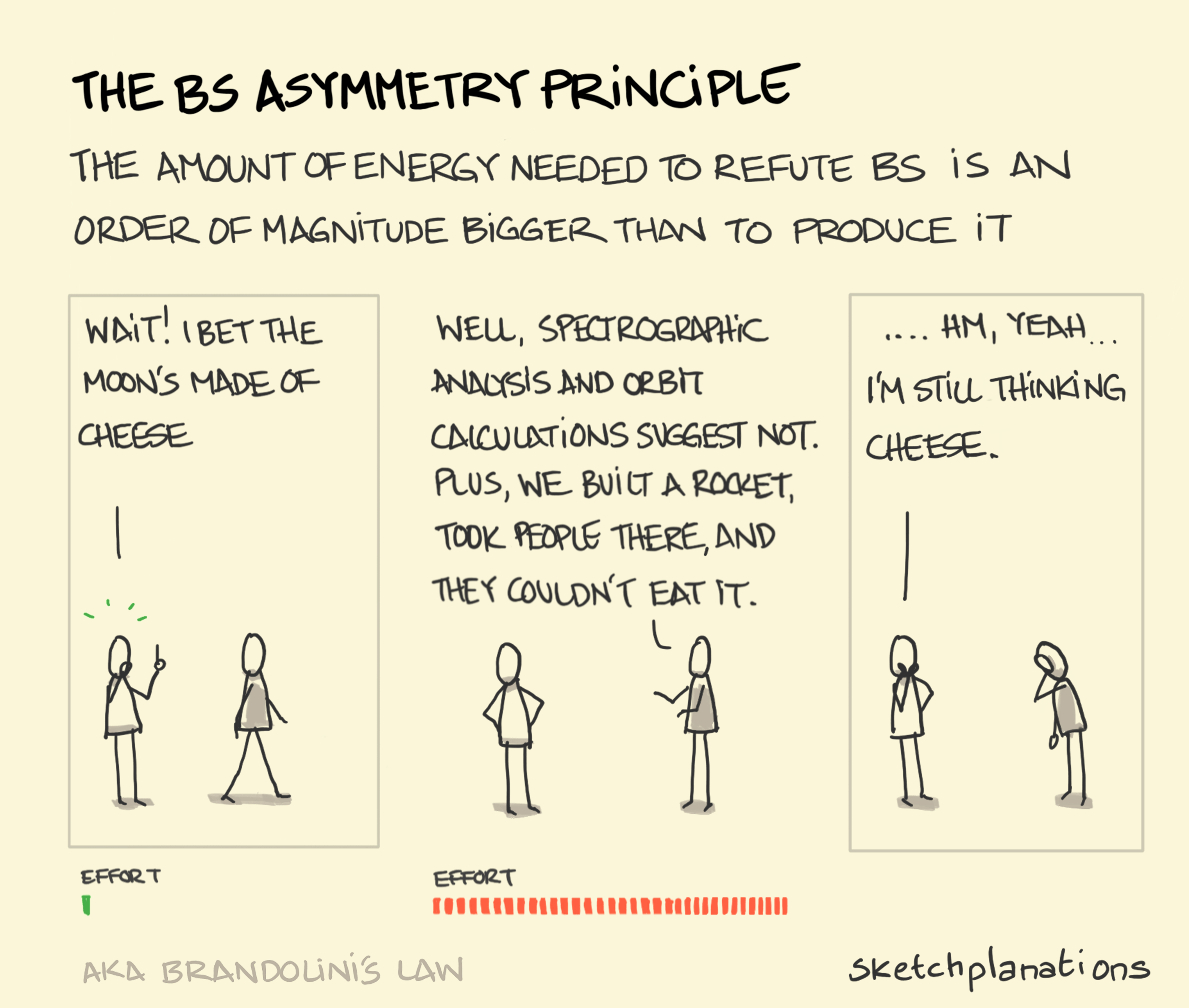

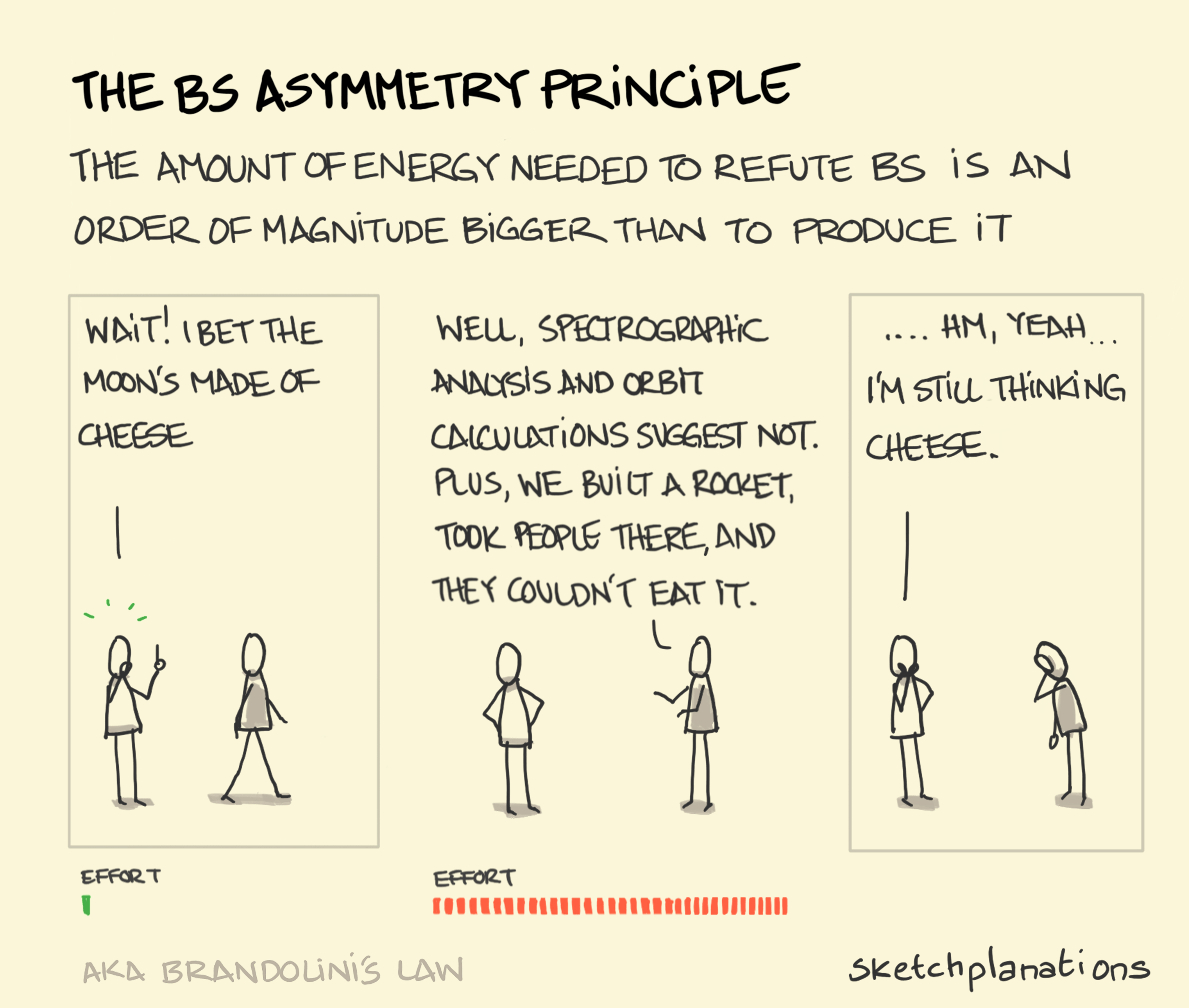

Problemet forstørres af det fænomen, som ofte kaldes Brandolinis lov: det er let og hurtigt at fremsætte en følelsesladet nonsens-påstand. Det er besværligt og tidskrævende, at formidle en grundig og sober demonstration af, hvorfor påstanden er nonsens. Det skaber en ubalance mellem arbejdsbyrden for vaccineskeptikere og forskere (som jeg selv har erfaring med, f.eks. her, her, her og her). Resultatet er, at der altid vil være mere vaccineskeptisk misinformation i omløb, end forskere kan imødegå og punktere. Selvom der findes utroligt dygtige forskere, der påtager sig ansvaret for oplysning af den offentlige debat (Roberto Burioni! Ben Goldacre!), så er der ganske enkelt ikke nok forskere, med nok tid til overs, til at luge ud i ukrudtet.

Af de samme grunde har jeg forsøgt at holde mig fra, at blande mig i debatten igen. Det er noget tid siden jeg rigtigt har fulgt litteraturen (andet end på hobby-niveau), og jeg har travlt med min egentlige forskning (lige nu om hvordan vi helt præcist skal definere straf, samt om diskrimination i kunstig intelligens).

I dag faldt jeg så i alligevel. Selvom man ikke kan forvente at udrydde vaccineskeptisk misinformation, så kan man godt fra tid til anden tage en tørn, og fjerne nogle af de værste tidsler. Og der er et par tidsler i debatten, som stikker mig så meget i øjet, at jeg ikke kan holde det ud. Så lad os kigge på et par af de værste ideer, som netop nu florerer.

(De værste? Okay, måske ikke de allerværste. Der findes en række myter om Corona-vacciner, som er så skøre, at de ikke er værd at bruge tid på, f.eks. at det er vaccinerne, som skaber de nye virusvarianter, at vaccination gør den vaccinerede infertil, at de omskriver den vaccineredes DNA(!), at de indeholder microchips designet til at spore personer(!?), og at de gør den vaccinerede magnetisk(!?!))

"Vi bruger børn til at beskytte de voksne!"

Argumentet er her følgende:

1) Vaccination af børn skader samlet set børnene, men gavner voksne, som nyder godt af øget flokimmunitet.

2) Det er forkert at skade børn, for at gavne voksne.

K) Det er forkert at vaccinere børn.

Argumentet er logisk gyldigt, så hvis præmisserne er sande, så er konklusionen det også. Der er imidlertid grund til at tvivle på begge præmisser.

Præmis 2 kan hvile enten på en generel ide, om at vi ikke må skade en person eller gruppe, for at gavne en anden person eller gruppe. Den generelle ide er imidlertid indlysende problematisk, for den type handling og politik er helt almindelig, og i de fleste tilfælde ukontroversiel. Hvis for eksempel byrådet beslutter at lave kommunens golfbane om til fodboldbaner, fordi langt flere vil få gavn af det sidste end af det første, så gavner de jo derved fodboldfans på bekostning af golffans. Det opfatter de færreste af os som problematisk.

Der hvor det typisk er oplagt problematisk at skade nogle, for at gavne andre, er hvis der er tale om en handling, som forårsager mere skade end gavn. Det kan dels skyldes handlingens karakter, men det kan også skyldes at handlingen rammer en særligt sårbar gruppe. Hvis en regering eksempelvis skærer i velfærdsydelser for en udsat gruppe, for at finansiere skattesænkninger for en allerede priviligeret gruppe, så kan det ofte være tilfældet, at omfordelingen skader langt mere end den gavner.

Den bedste måde at forsvare præmis 2 på er derfor nok at hævde, at børn er en særligt sårbar gruppe, som vi har særlige moralske forpligtelser overfor.

Selv hvis det er tilfældet, så er det ikke indlysende, at præmissen er sand i netop denne sammenhæng. Der må indlysende være grænser for, hvor meget vægt hensynet til børn skal have. Vi kan for eksempel forestille os, at Corona var langt mere dødbringende for voksne, men fortsat havde samme lave risici for børn. Hvis valget eksempelvis stod mellem at lade hundredetusindevis af voksne danskere dø eller at vaccinere børn, så ville de fleste nok mene, at vi var nødt til at vaccinere børnene. Uanset hvor stærkt behov man som forælder har for at beskytte sine børn (og det er imponerende stærkt, i hvert fald når man som lige præcis jeg, har været så heldig at få de uden tvivl mest vidunderlige børn i hele verden), så er det køligt betragtet altid et åbent spørgsmål, om vi i en given situation bør skade børn for at gavne voksne, hvis svar afhænger af balancen mellem hvor meget børn skades og de voksne gavnes.

Er vi så nødt til at lave den vanskelige afvejning? Nej, det er vi ikke. For det første præmis er falsk. Det er nemlig efter alt at dømme forkert, at vaccination af børn skader dem mere end det gavner dem. Tværtimod gavner Corona-vaccination både voksne og børn.

Gavn og risici ved Corona-vacciner

Hvorfor gavner vaccination efter alt at dømme børn? Fordi Corona-vacciner har en virkelig god risikoprofil. Det betyder at kun meget milde bivirkninger er almindelige, mens milde bivirkninger er sjældne, og alvorlige bivirkninger er så sjældne, at de næsten ikke kan måles pålideligt (her under i meget runde tal):

Omkring 30% af vaccinerede oplever tilsyneladende ingen bivirkninger overhovedet.

Omkring 50% oplever kortvarig (1-2 dage) stivhed og ømhed i skulderen.

Omkring 10-15% oplever kortvarig træthed, hovedpine og hævelse i skulderen.

Omkring 5-7% oplever kortvarige led- og muskelsmerter, kuldgysninger, kløe og/eller udslæt.

Omkring 3-4% oplever kortvarig feber og kvalme.

Det er naturligvis rarest at undgå alle bivirkninger, men selv de værste af de almindelige (omend relativt sjældne) bivirkninger er kun på niveau med eller mildere end de almindelige symptomer ved COVID. Hvis valget alene stod mellem at få en vaccine eller at blive smittet, så er der ingen tvivl om at det almindeligvis er langt værre at få sygdommen. Den giver større risiko for mere alvorlige symptomer i længere tid.

Det samme gør sig gældende for de mere alvorlige, men mere sjældne bivirkninger. Nyere studier har eksempelvis kigget på de alvorlige problemer med blodpropper, som har været rapporteret som bivirkning ved især AstraZeneca og Johnson & Johnson vaccinerne. Det viser sig, at risikoen for sådanne er langt højere, når man bliver smittet med Corona, end ved vaccinen.

Børn bliver som det er almindelig kendt mindre syge af COVID end voksne, men selv for børn er bivirkningerne ved vaccination så små eller sjældne, at det efter alt at dømme er bedst for børn at blive vaccineret. Det betyder, at vi i virkeligheden skal vælge, om vi vil gavne børn og gavne voksne, ved at vaccinere begge grupper, eller om vi vil skade begge grupper, ved ikke at vaccinere. Det valg er ikke vanskeligt.

"Vi kender ikke de langvarige risici ved vaccinerne!"

De væsentligste yderligere indvendinger forsøger at udfordre ideen om, at vaccination gavner børn. Den ene almindelige variant er påstanden, at vi ikke kender de langvarige risici ved at vaccinere.

Selvom de data vi har viser, at det på kort sigt er en fordel for børn at blive vaccineret, så kunne der godt vise sig at være langsigtede bivirkninger. Dem kan vi naturligvis ikke kende endnu. Men hvad nu hvis vaccinerne giver risiko for alvorlige bivirkninger, som først viser sig om 5 eller 10 år? Hvad nu, hvis vaccinen for eksempel forårsager autisme?

Indvendingen kan ikke afvises empirisk. Vi kan helt principielt ikke vurdere, hvilke ukendte, langsigtede risici en vaccine medfører. Men det betyder ikke, at den er en god grund til at afvise, at vaccinere. For at forklare hvorfor, er vi nødt til at snakke lidt om beslutningsteori.

I beslutningsteori skelner man mellem risici og usikkerheder. Risici er ting der kan ske, hvor vi kan sige i hvert fald et eller andet om, hvor sandsynligt det er, at de vil ske. Når vi ovenfor siger, at ca. 3-4% af vaccinerede, oplever feber og/eller kvalme, så er der tale om en risiko. Det har den fordel, at vi kan sammenligne fordele og ulemper, og eksempelvis beregne den forventede samlede effekt med såkaldt "expected utility theory".

Usikkerheder ("uncertain outcomes") er ting der kan ske, hvor vi ikke kan sige noget om, hvor sandsynligt det er, at de sker. Det kan være, at Corona-vacciner viser sig på lang sigt at give nogle mennesker blå pletter over hele kroppen. Men vi kan ikke på nuværende tidspunkt sige hvad risikoen for dette er. Er den 1/1.000.000? Måske 1/1.000.000.000.000? Eller 1/1.000.000.000.000.000.000? Vi har ingen anelse, og ingen oplagt måde at få nogen anelse om det. Hvad stiller vi så op?

I de situationer, hvor der er usikkerheder der taler imod en handling, og de (kendte) risici iøvrigt er i balance, der er det rimeligt at lade usikkerhederne tippe balancen. Måske er fordele og ulemper ved Corona-vaccination af børn endda så tæt, at man kunne argumentere for, at usikkerhederne bør tippe balancen (det tror jeg ikke, men der kunne måske være begrundet uenighed).

Men hvad med de situationer, hvor der er usikkerheder der både taler for og imod? For Corona-vaccination kender vi ikke, end ikke tilnærmelsesvis, sandsynligheden for endnu ukendte, langsigtede bivirkninger. Men vi kender heller ikke sandsynligheden for endnu ukendte, langsigtede skadevirkninger af Corona. Umiddelbart er der ingen grund til at tro, at de første skulle være mere (eller mindre) sandsynlige end de sidste.

Tilsvarende kender vi ikke sandsynligheden for endnu ukendte, langsigtede gavnlige effekter af vaccinerne, eller endnu ukendte, langsigtede gavnlige effekter af sygdommen (de kan lyde uplausible, men vi kigger på noget i den dur om et øjeblik).

Der er altså en række usikkerheder om ukendte langsigtede virkninger ved både sygdommen og vaccinen, som kunne være både skadelige og gavnlige. Hvad gør vi i den situation?

Det oplagte, og i forskningen alment anerkendte svar er, at vi ignorerer dem. Det ville være besynderligt kun at lægge vægt på nogle af dem, når vi ikke har grund til at tro, at nogle er mere sandsynlige end andre, eller at nogle er større effekter end andre. Og hvis vi tillægger dem alle samme vægt, så udligner de hinanden.

"Immunforsvaret bliver stærkere af sygdommen end af vaccinen!"

En sidste indvendig forbindes i dansk kontekst især med professor Christine Stabell Benn. Benns arbejde fokuserer i almindelighed på at vise, at det har gavnlige effekter, når immunforsvaret "trænes".

Mere specifikt er hendes hypotese, som meget af hendes forskning undersøger, at der kan være sundhedsmæssige fordele ved at blive smittet snarere end vaccineret, eller ved at blive vaccineret med de typer vacciner, som indeholder levende, svækkede patogener fremfor andre typer vacciner. Hypotesen er, lidt bredt formuleret, at immunforsvaret bliver stærkere af at tage kampen op mod et egentligt patogen, end ved at slås med stedfortrædere.

I sammenhæng med børnevaccinationer er ideen så følgende:

1) Bivirkningerne ved Corona-vaccination er mindre skadelige end symptomerne ved smitte med Corona.

2) Den gavnlige effekt ved smitte med Corona (immunitet) er større end ved Corona-vaccination.

3) For netop børn er forskellen mellem symptomer og bivirkninger (jf. 1) så lille, at den bedre immunitet ved smitte overstiger de større ulemper ved smitte.

K) Vi skader børn ved at vaccinere dem, fordi vi derved berøver dem en stor fordel (øget immunitet) for at give dem en lille fordel (færre ulemper ved bivirkninger end ved symptomer).

Argumentet er (næsten) gyldigt (strengt taget er de to første præmisser blot baggrund for den tredje præmis, og der er en implicit præmis, om at vi skader nogen, hvis vi tager en stor fordel fra dem for at give dem en lille fordel, men det her er ikke en fagtidsskriftsartikel). Hvad med præmisserne?

Det er værd at bemærke, at præmis 1) ofte ikke anerkendes af vaccine-skeptikere. Det bør den imidlertid, som vi ovenfor har set, så det er gavmildt overfor dem, at anvende den her, når argumentet stadig kan gennemføres.

Præmis 3) er empirisk usikker (det afhænger af en præcis vurdering), men lad os blot for argumentets skyld sige, at hvis de to første præmisser var sande, så ville den også være det. Det efterlader kun præmis 2). Hvad skal vi mene om den?

Man skal være overordentlig forsigtig med at kaste sig ud i at vurdere videnskab udenfor sit eget fagområde. Det kræver som minimum, at man er villig til at afsætte meget væsentlige ressourcer (læs: flere måneders fuldtidsarbejde). Af samme grund tør jeg ikke vurdere Benns arbejde, eller om den generelle hypotese er plausibel.

Til gengæld kan man godt kigge på, hvad forskningen siger om Corona-vacciner specifikt. Der er nemlig lavet en lang række studier af, hvor god beskyttelse man opnår ved at blive henholdsvis vaccineret og smittet. De opsummeres af blandt andet de britiske immunologers selskab, og det amerikanske Centre for Disease Control. Særligt interessant er to nyere studier, som samler op på forskningen, henholdsvis Shenai et al. og Bozie et al.

Hvis man kort skal opsummere hvad vi ved lige nu, så er det sådan cirka:

Der er fortsat så lidt data, og meget af det har så ringe kvalitet, at det er vanskeligt at vurdere spørgsmålet med høj sikkerhed.

De foreliggende data synes at vise, at vacciner og smitte er nogenlunde lige gode til at forhindre, at man bliver smittet igen. Det gælder også for de nyere varianter af Corona.

Til gengæld vil yderligere vacciner med stor sikkerhed give endnu bedre beskyttelse, uanset om der er tale om det tredje stik for allerede vaccinerede, eller det første for tidligere smittede (se især Shenai et al.).

Vaccination er måske lidt bedre end tidligere smitte til at forhindre de mest alvorlige symptomer ved Corona, herunder hospitalsindlæggelse (se især Bozie et al.).

Man kan altså mene hvad man vil om den mere generelle hypotese, men der synes ikke at være noget, i de forhåndenværende data, som tyder på, at smitte med netop Corona giver væsentligt bedre (eller værre) beskyttelse end vaccination. Præmis 2 er falsk, og argumentet slår fejl.

Vaccine-skepsis redux redux

Tre af de mest almindelige indvendiger mod Corona-vaccination af børn slår fejl. Det vil næppe anfægte skeptikerne. Vaccine-skeptikere er (ligesom andre mennesker i lignende situationer) så godt som umulige at få til at skifte mening med noget så luftigt som argumenter.

Men de som blot måtte være usikre, og de der (som jeg selv) bliver gnavne over dårlige ræssonementer i den offentlige debat, kan med ro i sjælen ignorere strømmen af misinformation, og give sig selv og deres børn vaccinen. Også selvom der faktisk findes statistisk

signifikante sammenhænge mellem vacciner og autisme.